Dürfen vier Jahre alte Studien zur digitalen Transformation heute noch zitiert werden? 2014 war laut MIT das Jahr mobiler Kooperation und McKinsey das Rechnungswesen zu einem Drittel als „mit verfügbaren Mitteln automatisierbar“ deklariert. Vom Controlling wird im Spannungsbogen von Big Data Potentialen und Fachkräftemangel Flexibilität, Verständnis für das Geschäftsmodell und eine strategische Unterstützung erwartet. Das scheinen gute Vorzeichen für den Durchbruch einer Finance Automation und stärkere Ausrichtung hin zu mehr interner Kommunikation zu sein? Letzteres erfordert individuelle Fähigkeiten, die erfolgreiche Automatisierung ist Ergebnis vorab standardisierter, von menschlicher Ermessensentscheidung befreiter Prozesse.

Der CFO Indicator Bericht von Adaptive Insights hat zur Finance Automation hunderte CFOs interviewt. Die Kernaussagen lassen sich in einer Hypothese zusammenfassen: CFOs wünschen sich in 2018 tiefer gehende visuelle Analysen und Berichte, mehr Investments in Technologie und die Entwicklung professioneller Fähigkeiten im Team. Das kann als ein Fehlen an Daten, Infrastruktur und Fähigkeiten gelesen werden, eben dass „die Daten für angefragte Analysen stehen meistens nicht parat“. Nun denn, mit der richtigen Investition soll es klappen. Keine leichte Aufgabe für die Stelle in der Informationsflüsse zusammenlaufen und die Geschichte von Heute und Morgen geschrieben werden soll.

Wer und was treibt die Entwicklung?

Die Hälfte der Führungskräfte spürt den Druck digitaler Transformation durch Kollegen, doch bitte die Automatisierung der Datenbasis voran zu treiben. Die Ablösung abteilungsspezifischer Silos ist ein Anliegen, dass die hauptsächlich amerikanischen Finanzer dabei als umsetzbar ansehen. Wichtiger ist die Implikation, dass Finance schon bei der Hälfte als Treiber einer zeitnahen, qualitativ hochwertigen Informationsversorgung akzeptiert ist.

Der Mangel an Standardisierung wird angemerkt. In der Regel existiert eine Variantenvielfalt, die eine Automatisierung schon auf Systemebene erschwert. Mangelnder Gestaltungswillen der – dann „gewachsenen“ – Geschäftsprozesse ist ein Haupt-Treiber der Vielfalt. Eine frei gewachsene Wiese erzeugt eine Vielfalt an Blumen, leider weniger geeignet für eine effiziente Ernte als die Tulpenbeete unserer holländischen Nachbarn.

Im Fokus der nächsten 18 Monate

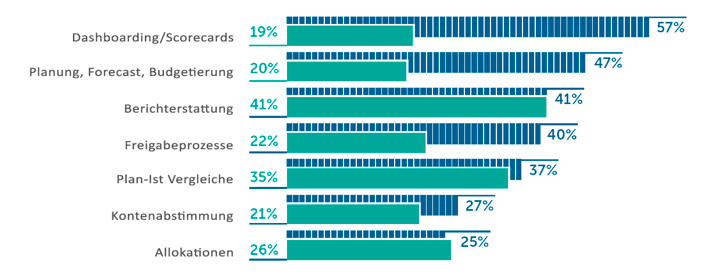

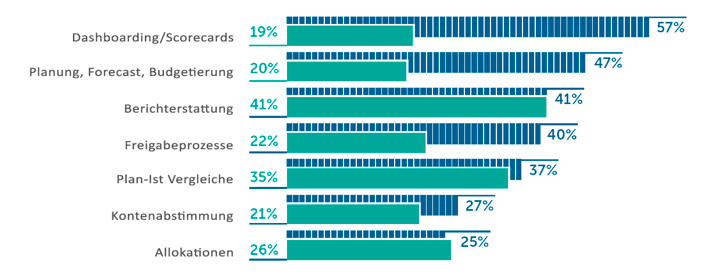

Die Studie stellt in Folge den Lebenszyklus der Automatisierung deutlich dar. Aufgaben in stark frequentierten Prozessen, wie dem Monatsabschluss, sind besonders häufig automatisiert. Prozess-Schritte mit Ermessensentscheidungen sind weniger häufig automatisiert. Dabei stehen Dashboards und Planung/ Forecasts oben auf der Automatisierungs-Wunschliste.

Letzteres verspricht eine vermeintliche Sicherheit. Statistisch validierte Vorhersagen sind erstens zu verstehen und zweitens laufend auf ihre Validität zu prüfen. Der Weg zu Predictive und Prescriptive Forecasting ist lang und erfordert einen für Finance Verhältnisse großen Datenbestand. Viele der CFOs werden bei der Beantwortung eher an eine Treiber-basierte Planung gedacht haben.

Zur Notwendigkeit der Automatisierung

Die Reduktion von Kosten steht interessanterweise nur bei jedem 50. CFO im Vordergrund. Die Hauptkriterien der CFOs für die Durchführung einer Automatisierung sind:

- eine qualitativ hochwertige Datenbasis zur Entscheidungsfindung – besonders im Mittelstand scheint Aufholbedarf zu bestehen,

- Zeit für wertschöpfende Aufgaben schaffen und Mitarbeiter zu entlasten,

- Die Produktivität der Abteilung und Wahrnehmung im Unternehmen insgesamt zu erhöhen und

- eine treffsichere Planung zu ermöglichen.

Die Fähigkeiten im Team und das Ergebnis der Arbeit ist geprägt durch die Verifikation und Validierung der Berichte, Analysen und Datenquellen. Gefühlt steht knapp ein Arbeitstag für Punkt 2 zur Verfügung. Das Gehaltsgefüge verspricht eine andere Gewichtung.

Fehlt die Möglichkeit der Standardisierung, halten CFOs eine Anwendung Künstlicher Intelligenz bis 2023 für möglich. Künstliche Intelligenz im Controlling ist noch rar gesät. In den bekannten Fällen stellt sich der initiale oder in Folge propagierte Erfolg „trainierter“ Algorithmen selten ein.

[bctt tweet=““Die Reduktion von Kosten steht interessanterweise nur bei jedem 50. CFO im Vordergrund.“ CFO Indicator Report“ via=“no“]

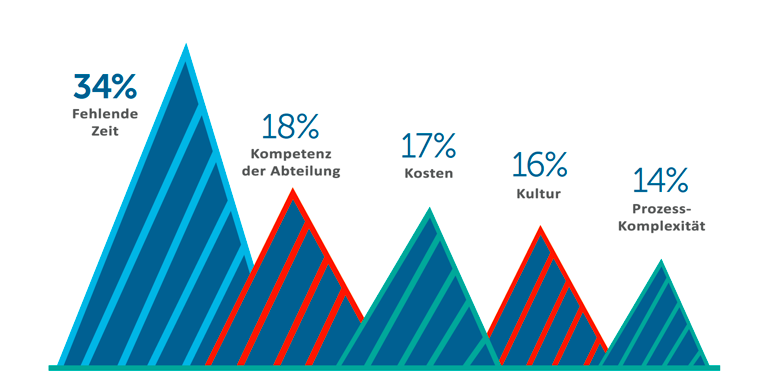

Trotz alledem, bisherige Bestrebungen werden zu zwei Dritteln als Erfolg bejaht. Dabei

- existiert eine Disparität zwischen „Einsparung an Zeit“ und „Fehlende Zeit“ als „#1 erreichtes Ziel“ und „#1 Verhinderungsgrund“,

- soll das Controlling technologisch fortschrittlicher und in Folge rutscht Excel als notwendige Fähigkeit von 78% in 2016 auf heuer ganze 7% ab.

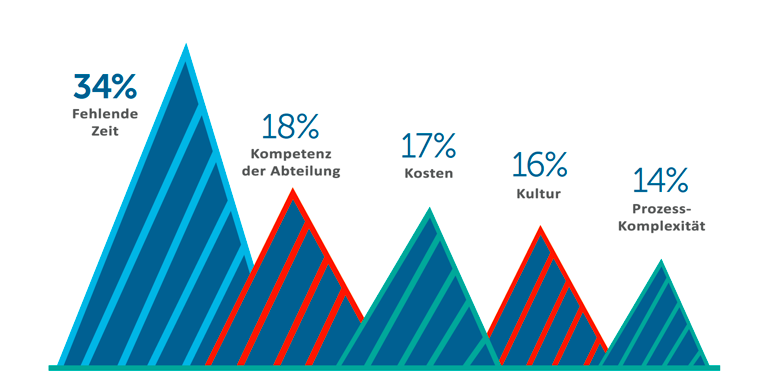

Gründe, die eine stärkerer Automatisierung in Controlling und FP&A verhindern.

Der Blick in die Vergangenheit lohnt sich. Im Bereich der Abschlussautomatisierung scheint einiger erreicht, die Datenflut wirft neue Herausforderungen auf. Herausforderung bleibt das Methoden-Verständnis zu Standardisierung und Automatisierung und das Einfinden in der dem diametral entgegenstehenden Rolle als interner Kommunikator. Der Terminkalender des Controllings wird in naher Zukunft weiter wenig Zeit für tiefergehende Analysen bereithalten. Diese Zeit müssen wir uns nehmen.

Lesen Sie den CFO Indicator Report hier.